ISPRS Journal of Photogrammetry and Remote Sensing ( IF 10.6 ) Pub Date : 2020-12-09 , DOI: 10.1016/j.isprsjprs.2020.11.022 Yulin Yan , Youngryel Ryu

|

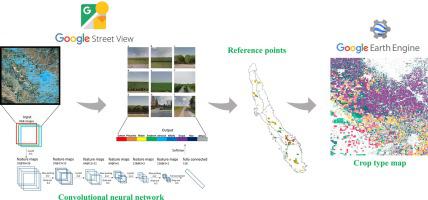

Ground reference data are an essential prerequisite for supervised crop mapping. The lack of a low-cost and efficient ground referencing method results in pervasively limited reference data and hinders crop classification. In this study, we apply a convolutional neural network (CNN) model to explore the efficacy of automatic ground truthing via Google Street View (GSV) images in two distinct farming regions: Illinois and the Central Valley in California. We demonstrate the feasibility and reliability of our new ground referencing technique by performing pixel-based crop mapping at the state level using the cloud-based Google Earth Engine platform. The mapping results are evaluated using the United States Department of Agriculture (USDA) crop data layer (CDL) products. From ~ 130,000 GSV images, the CNN model identified ~ 9,400 target crop images. These images are well classified into crop types, including alfalfa, almond, corn, cotton, grape, rice, soybean, and pistachio. The overall GSV image classification accuracy is 92% for the Central Valley and 97% for Illinois. Subsequently, we shifted the image geographical coordinates 2–3 times in a certain direction to produce 31,829 crop reference points: 17,358 in Illinois, and 14,471 in the Central Valley. Evaluation of the mapping results with CDL products revealed satisfactory coherence. GSV-derived mapping results capture the general pattern of crop type distributions for 2011–2019. The overall agreement between CDL products and our mapping results is indicated by R2 values of 0.44–0.99 for the Central Valley and 0.81–0.98 for Illinois. To show the applicational value of the proposed method in other countries, we further mapped rice paddy (2014–2018) in South Korea which yielded fairly well outcomes (R2 = 0.91). These results indicate that GSV images used with a deep learning model offer an efficient and cost-effective alternative method for ground referencing, in many regions of the world.

中文翻译:

通过深度学习探索Google Street View,以进行作物类型映射

地面参考数据是有监督作物作图的必要先决条件。缺乏低成本和有效的地面参考方法会导致参考数据普遍受限,并阻碍作物分类。在这项研究中,我们应用了卷积神经网络(CNN)模型,以通过Google街景(GSV)图像在两个不同的农业地区(伊利诺伊州和加利福尼亚州的中央山谷)探索自动地面实测的功效。通过使用基于云的Google Earth Engine平台在状态级别执行基于像素的作物映射,我们证明了我们新的地面参考技术的可行性和可靠性。使用美国农业部(USDA)作物数据层(CDL)产品评估映射结果。从大约130,000个GSV图像中,CNN模型识别了大约9,400个目标作物图像。这些图像可以很好地分类为农作物类型,包括苜蓿,杏仁,玉米,棉花,葡萄,水稻,大豆和开心果。中央山谷地区的整体GSV图像分类精度为92%,伊利诺伊州为97%。随后,我们在特定方向上将图像地理坐标移动了2-3次,以生成31,829个作物参考点:伊利诺伊州为17,358,中央谷地为14,471。用CDL产品评估映射结果显示出令人满意的一致性。GSV得出的作图结果反映了2011-2019年作物类型分布的一般模式。R表示CDL产品与我们的映射结果之间的总体协议 中央山谷地区的整体GSV图像分类精度为92%,伊利诺伊州为97%。随后,我们将图像地理坐标沿某个方向移动了2-3次,以生成31,829个作物参考点:伊利诺伊州为17,358,中央谷地为14,471。用CDL产品评估映射结果显示出令人满意的一致性。GSV得出的作图结果反映了2011-2019年作物类型分布的一般模式。R表示CDL产品与我们的映射结果之间的总体协议 中央山谷地区的整体GSV图像分类精度为92%,伊利诺伊州为97%。随后,我们在特定方向上将图像地理坐标移动了2-3次,以生成31,829个作物参考点:伊利诺伊州为17,358,中央谷地为14,471。用CDL产品评估映射结果显示出令人满意的一致性。GSV得出的作图结果反映了2011-2019年作物类型分布的一般模式。R表示CDL产品与我们的映射结果之间的总体协议 用CDL产品评估映射结果显示出令人满意的一致性。GSV得出的作图结果反映了2011-2019年作物类型分布的一般模式。R表示CDL产品与我们的映射结果之间的总体协议 用CDL产品评估映射结果显示出令人满意的一致性。GSV得出的作图结果反映了2011-2019年作物类型分布的一般模式。R表示CDL产品与我们的映射结果之间的总体协议2个值,中央谷地为0.44–0.99,伊利诺伊州为0.81–0.98。为了显示该方法在其他国家的应用价值,我们进一步绘制了韩国稻田(2014–2018)的图,该稻田的收成相当好(R 2 = 0.91)。这些结果表明,在世界许多地区,与深度学习模型一起使用的GSV图像为地面参考提供了一种有效且具有成本效益的替代方法。

京公网安备 11010802027423号

京公网安备 11010802027423号