当前位置:

X-MOL 学术

›

WIREs Data Mining Knowl. Discov.

›

论文详情

Our official English website, www.x-mol.net, welcomes your feedback! (Note: you will need to create a separate account there.)

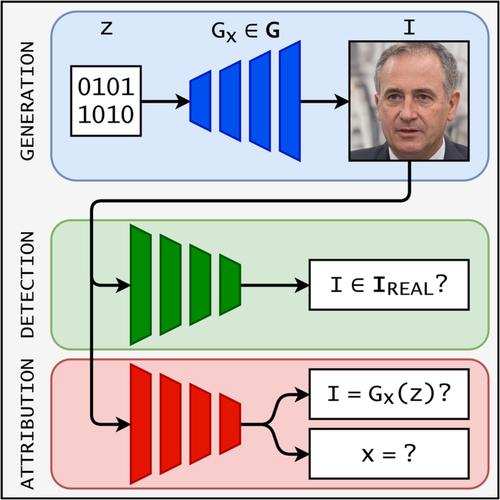

Deepfake attribution: On the source identification of artificially generated images

WIREs Data Mining and Knowledge Discovery ( IF 7.8 ) Pub Date : 2021-12-03 , DOI: 10.1002/widm.1438 Brandon Khoo 1 , Raphaël C.‐W. Phan 1, 2 , Chern‐Hong Lim 1

WIREs Data Mining and Knowledge Discovery ( IF 7.8 ) Pub Date : 2021-12-03 , DOI: 10.1002/widm.1438 Brandon Khoo 1 , Raphaël C.‐W. Phan 1, 2 , Chern‐Hong Lim 1

Affiliation

|

Synthetic media or "deepfakes" are making great advances in visual quality, diversity, and verisimilitude, empowered by large-scale publicly accessible datasets and rapid technical progress in deep generative modeling. Heralding a paradigm shift in how online content is trusted, researchers in digital image forensics have responded with different proposals to reliably detect AI-generated images in the wild. However, binary classification of image authenticity is insufficient to regulate the ethical usage of deepfake technology as new applications are developed. This article provides an overview of the major innovations in synthetic forgery detection as of 2020, while highlighting the recent shift in research towards ways to attribute AI-generated images to their generative sources with evidence. We define the various categories of deepfakes in existence, the subtle processing traces and fingerprints that distinguish AI-generated images from reality and each other, and the different degrees of attribution possible with current understanding of generative algorithms. Additionally, we describe the limitations of synthetic image recognition methods in practice, the counter-forensic attacks devised to exploit these limitations, and directions for new research to assure the long-term relevance of deepfake forensics. Reliable, explainable, and generalizable attribution methods would hold malicious users accountable for AI-enabled disinformation, grant plausible deniability to appropriate users, and facilitate intellectual property protection of deepfake technology.

中文翻译:

Deepfake 归因:关于人工生成图像的来源识别

合成媒体或“深度伪造”在视觉质量、多样性和逼真度方面取得了巨大进步,这得益于大规模可公开访问的数据集和深度生成建模的快速技术进步。数字图像取证领域的研究人员预示着如何信任在线内容的范式转变,他们提出了不同的建议,以可靠地检测野外 AI 生成的图像。然而,随着新应用的开发,图像真实性的二元分类不足以规范 deepfake 技术的道德使用。本文概述了截至 2020 年在合成伪造检测方面的主要创新,同时强调了最近研究转向将 AI 生成的图像归因于有证据的生成源的方法。我们定义了存在的各种深度伪造品、将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对启用人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。和新研究的方向,以确保深度伪造取证的长期相关性。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。和新研究的方向,以确保深度伪造取证的长期相关性。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。

更新日期:2021-12-03

中文翻译:

Deepfake 归因:关于人工生成图像的来源识别

合成媒体或“深度伪造”在视觉质量、多样性和逼真度方面取得了巨大进步,这得益于大规模可公开访问的数据集和深度生成建模的快速技术进步。数字图像取证领域的研究人员预示着如何信任在线内容的范式转变,他们提出了不同的建议,以可靠地检测野外 AI 生成的图像。然而,随着新应用的开发,图像真实性的二元分类不足以规范 deepfake 技术的道德使用。本文概述了截至 2020 年在合成伪造检测方面的主要创新,同时强调了最近研究转向将 AI 生成的图像归因于有证据的生成源的方法。我们定义了存在的各种深度伪造品、将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对启用人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。将 AI 生成的图像与现实以及彼此区分开来的细微处理痕迹和指纹,以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。以及当前对生成算法的理解可能存在的不同程度的归因。此外,我们描述了合成图像识别方法在实践中的局限性,旨在利用这些局限性的反取证攻击,以及确保深度伪造取证长期相关性的新研究方向。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。和新研究的方向,以确保深度伪造取证的长期相关性。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。和新研究的方向,以确保深度伪造取证的长期相关性。可靠、可解释和可概括的归因方法将使恶意用户对支持人工智能的虚假信息负责,向适当的用户提供合理的否认,并促进对 deepfake 技术的知识产权保护。

京公网安备 11010802027423号

京公网安备 11010802027423号